The Washington Post'un haberine göre, İsrail, yıllar önce istihbarat birimini bir yapay zeka test alanına dönüştürdü ve bu durum üst düzey komutanlar arasında insanların karar alma süreçlerinde ne kadar devrede olduğu konusunda bir tartışma başlattı. 7 Ekim 2023'teki Hamas saldırısından sonra İsrail Savunma Kuvvetleri (IDF), yıllardır büyük bir dikkatle derlenen ve militan grubun ev adresleri, tünelleri ve diğer kritik altyapılarını içeren bir veritabanına dayanarak Gazze'yi yoğun bir şekilde bombaladı.

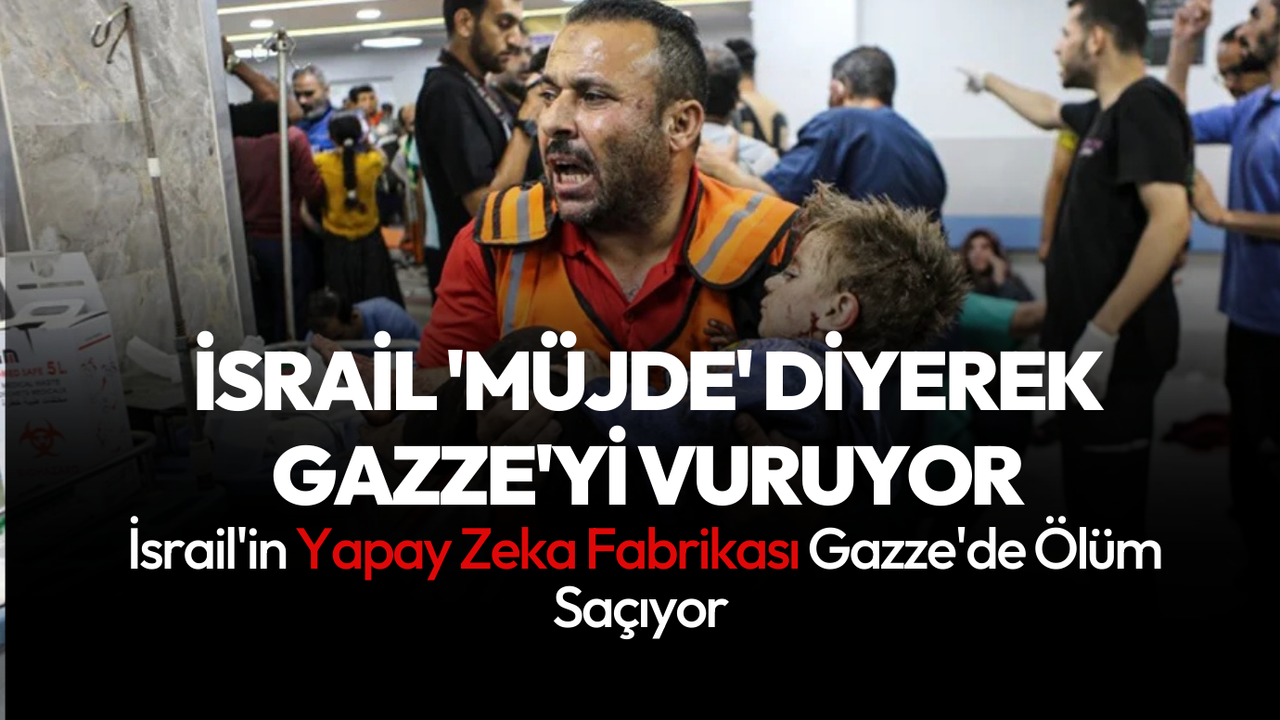

Ancak hedef bankası tükendiğinde, IDF, “Müjde” anlamına gelen Habsora adlı karmaşık bir yapay zeka aracına yöneldi. Bu araç, kısa sürede yüzlerce yeni hedef üretebilmekteydi. The Washington Post'un aktardığına göre, yapay zekanın kullanımı, IDF'nin hedef bankasını hızla doldurarak operasyonlarını kesintisiz sürdürmesine olanak sağladı.

Haberde, bu sistemin, İsrail'in son 14 ay boyunca Gazze'de yürüttüğü savaşa nasıl katkı sağladığı anlatılıyor. Ayrıca, bu programın geliştirilme süreciyle ilgili daha önce bildirilmemiş ayrıntılar ve ordunun üst düzey kademelerinde, yapay zeka destekli istihbaratın kalitesine ilişkin sert tartışmalar olduğu da belirtiliyor. Bazı eleştirmenler, bu teknolojinin Gazze'deki can kaybını hızlandırdığını savunuyor.

Haberde, Gazze Sağlık Bakanlığı'nın verilerine göre, savaşta hayatını kaybedenlerin sayısının 45.000’i aştığı belirtiliyor. Ancak IDF, bu verilerin Hamas kontrolünde olduğunu ve güvenilmez olduğunu iddia ediyor. IDF’ye yakın kaynaklar, ordunun kabul edilebilir sivil kayıp sayısını tarihsel normların ötesine genişlettiğini, bunun da otomasyon sayesinde mümkün olduğunu öne sürüyor.

Washington Post'un haberinde, 2014 yılında, IDF'nin bir yüksek düzey 'terörist' için kabul edilebilir sivil kayıp oranının 1 olduğu, ancak Gazze'deki savaş sırasında bu sayının düşük düzeyde bir Hamas üyesi için 15'e yükseldiği, orta ve üst düzey üyeler için ise bu oranın "katlanarak" arttığı ifade ediliyor.

Ayrıca, IDF'nin 2020'den itibaren birimlerinde mühendislerin sayısını artırdığı ve dil uzmanlarının sayısını azalttığı belirtiliyor. Haberde, yapay zekanın hızlı hedef belirleme yeteneği kazandırdığı, ancak doğruluk ve etik kaygıları beraberinde getirdiği vurgulanıyor.

The Washington Post'un detaylı incelemesine göre, IDF'nin kullandığı yapay zeka sistemleri arasında "Lavender" ve "Hunter" gibi araçlar bulunuyor. Bu araçlar, hem hedef belirleme hem de operasyonlarda daha hızlı karar alınmasını sağlamak için geliştirildi. Ancak, bazı üst düzey yetkililer, bu teknolojilerin insan faktörünü ve geleneksel uyarı kültürünü aşındırdığına inanıyor. Habere göre, IDF içindeki bu değişim, 7 Ekim saldırısına hazırlıksız yakalanılmasının ana nedenlerinden biri olarak görülüyor.

The Washington Post’un haberine göre, IDF’nin Habsora adlı yapay zeka sistemi, savaşın hızını kesintiye uğratmadan yüzlerce yeni hedef oluşturdu. Bu sistem, IDF'nin son 14 ay boyunca Gazze'de yürüttüğü savaştaki rolünün örneklerinden biri. On yıldan uzun süredir devam eden bu program, IDF'nin istihbarat operasyonlarının merkezine gelişmiş yapay zeka araçlarını yerleştirmeyi amaçlıyor.

The Washington Post'un araştırmasına göre, Habsora gibi sistemler, dünya çapında konuşulan en gelişmiş askeri yapay zeka girişimlerinden biri olarak kabul ediliyor. Ancak bu teknolojilerin geliştirilme süreci ve uygulamalarıyla ilgili daha önce bildirilmemiş detaylar ortaya çıktı. Haberde, bu süreçte üst düzey askeri liderler arasında, yapay zekanın sağladığı istihbaratın kalitesi, bu bilgilerin yeterince denetlenip denetlenmediği ve bu odaklanmanın IDF'nin genel istihbarat yeteneklerini zayıflatıp zayıflatmadığına dair sert tartışmalar yaşandığı belirtiliyor.

Haberde, bazı askerlerin, teknolojinin doğruluk payı hakkında endişelerini dile getirdiği belirtiliyor. Yapay zeka sistemlerinin ürettiği tahminlerin, insan analistlerin oluşturduğu verilerle aynı doğrulukta olup olmadığı konusunda soru işaretleri bulunuyor. Örneğin, Gazze’deki bombalama kampanyalarında yapay zekanın sivil kayıpları tahmin etmek için kullanılan yöntemlerinin oldukça basitleştirilmiş olduğu ifade ediliyor. Sistem, bir binadaki sivil varlığını, binadaki telefon sinyallerine dayalı olarak değerlendiriyor. Ancak bu yaklaşım, kapalı telefonları ya da telefon taşımayan çocukları hesaba katmıyor.

Bir asker, “Eskiden bir binayı bombalamadan önce insanlarla iletişime geçerek orada olup olmadıklarını teyit ederdik. Bu süreç daha uzun sürerdi, ancak daha doğru olurdu,” diyerek endişelerini dile getirdi.

Hedefleme Sürecindeki Risklerle Dolu

The Washington Post’un haberine göre, bazı askerler, yapay zekanın hedefleme sürecindeki etkisine dair derin endişelerini dile getiriyor. Örneğin, savaş sırasında hedefleme süreci hızlandırıldı ve doğrulama gereklilikleri gevşetildi. Bu bağlamda, yapay zeka sistemlerinden biri olan Lavender, Gazze'deki bireylerin gerçek zamanlı fotoğraflarını elde ederek, bu kişilerin Hamas üyeleriyle eşleşip eşleşmediğini kontrol etmek için yüz tanıma araçlarını kullandı. Ancak askerler, bu eşleşmelerin doğruluğundan emin olmadıklarını ve bu kişilerin gerçekten aktif birer militan olup olmadığının doğrulanmadığını belirtiyor.

Bazı durumlarda, IDF komutanlarının hedeflenen bireylerin aile üyelerinin de saldırılarda ölebileceğini kabul ettiği ifade ediliyor. The Washington Post’a konuşan bir asker, “Bu durum, orantılılık ilkelerinin arka plana atıldığını gösteriyor,” dedi.

Uluslararası İnsancıl Hukuk, savaşan tarafların saldırılardaki askeri avantajı beklenen sivil kayıplarla dengelemesini şart koşar. Ancak bu hukukun, yapay zekanın savaşta kullanımıyla ilgili açık bir düzenlemesi yok. IDF, yaz aylarında yaptığı bir açıklamada, yapay zeka sistemlerinin kullandığı hedefleme süreçlerinin uluslararası hukuka uygun olduğunu savundu. IDF, bu sistemlerin doğru bir şekilde bilgi toplayarak yan hasarı en aza indirdiğini ve hedefleme sürecini daha hassas hale getirdiğini iddia ediyor.

Bununla birlikte, haberde yer alan bazı kaynaklar, savaş sırasında IDF’nin orantılılık ilkesini ihlal ettiğini öne sürüyor. Örneğin, IDF’nin 2023 yılındaki açıklamasında, Gospel adlı yapay zeka sisteminin Gazze'deki 12.000 hedefin vurulmasına yardımcı olduğu belirtildi. Bu süreçte saniyeler içinde yüzlerce saldırı gerçekleştirildi.

Haberde, IDF’nin yapay zeka sistemlerinde önemli teknik zorluklarla karşılaştığı da aktarılıyor. Örneğin, yapay zeka sistemlerinden bazıları, dil analizi yaparken Arapça’daki önemli deyimleri ve kelimeleri anlamakta zorlandı. IDF içindeki bazı liderler, bu teknolojilerin doğruluk oranının bir insan analistin sağladığı bilgilerden daha düşük olduğunu dile getirdi.

Ayrıca, üst düzey komutanların günlük istihbarat raporlarında, bilginin kaynağının yapay zeka mı yoksa insan analistler mi olduğunu bilmediği ifade ediliyor. Eski bir askeri yetkili, “Bu iki bilgi türü aynıymış gibi ele alındı. Raporu hazırlayan kişi bile bu farkı bilmiyor olabilir,” dedi.

Yapay Zeka ve Komuta Kültüründeki Değişim

The Washington Post’un haberine göre, IDF içinde uzun süredir var olan “uyarı kültürü” yapay zekanın artan etkisi nedeniyle zayıfladı. Daha önce, düşük düzeyli analistler bile üst düzey komutanlara doğrudan uyarıda bulunabiliyordu. Ancak yapay zekaya olan güvenin artmasıyla bu uyarı mekanizmasının zarar gördüğü belirtiliyor.

Haberde, 7 Ekim saldırısından önce Hamas’ın saldırı planlarını tespit eden deneyimli bir analistin, üst düzey komutanlarla zamanında bir toplantı yapamadığı da aktarılıyor. Bu durum, “yapay zekanın insan faktörünü devre dışı bırakmasının” tehlikelerine örnek olarak gösteriliyor.

IDF’nin sinyal istihbaratı birimi 8200’ün lideri Yossi Sariel, yapay zeka kullanımına öncülük eden isimlerden biri. Haberde, Sariel’in 2020 yılında bu birimin liderliğini devralmasının ardından birimin odak noktasını mühendislik ve teknolojiye kaydırdığı belirtiliyor. Sariel, yüzlerce algoritmanın yer aldığı bir sistem olan Gospel’in geliştirilmesini savundu. Bu sistem, büyük miktarda veri analiz ederek hedefleri hızlı bir şekilde belirleme yeteneğine sahip.

Sariel’in liderliği sırasında 8200 birimindeki dil uzmanlarının sayısının azaltıldığı ve birimin çalışanlarının yüzde 60’ının mühendislik rollerinde görev aldığı ifade ediliyor. Ancak, haberde bazı eski komutanların bu değişimlere karşı çıktığı ve yapay zekaya yönelik “dini bir bağlılık” geliştirilmesine karşı uyarılarda bulunduğu aktarılıyor.